"Estas declaraciones belicistas y que violentan el Derecho Internacional, configuran una amenaza explícita de uso de la fuerza, que quebrantan la Carta de las Naciones Unidas y a las vez lesionan todas las normas de la Organización de Aviación Civil Internacional al intervenir sobre la soberanía de un país y su propio espacio aéreo", sentenciaron desde el sector político.

Agustín Courtoisie

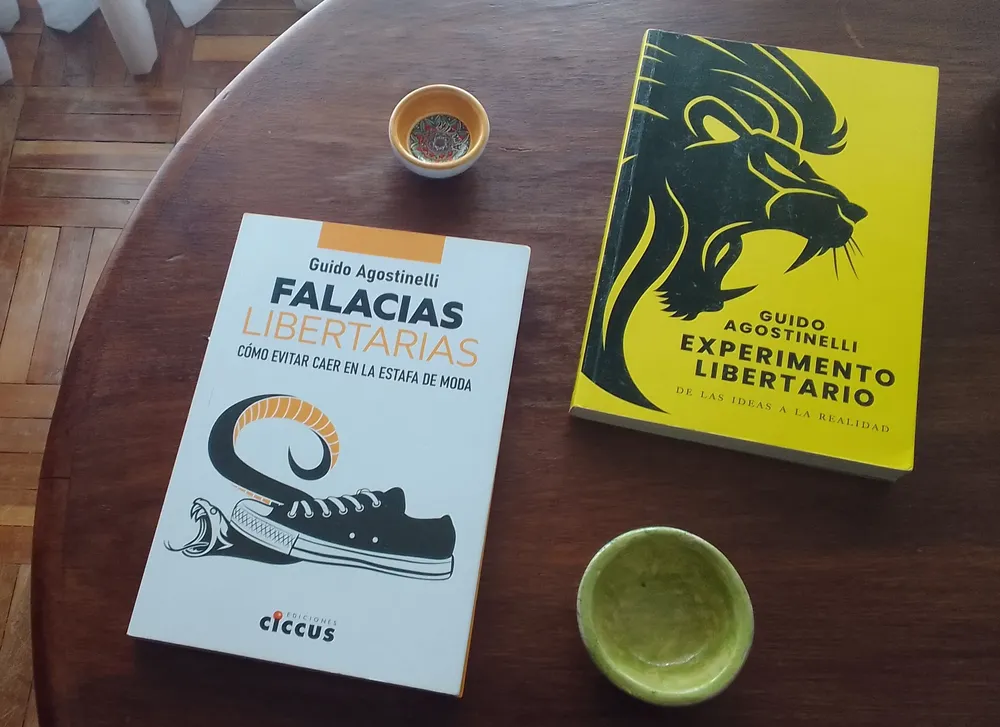

Mediateca04/12/2025Guido Agostinelli es mucho más que sus libros. Porque recorre el mundo para dar versiones de primera mano de todo lo que ocurre en economía y finanzas. Y es un verdadero cruzado contra las falacias neoliberales y libertarias. El autor despliega una incesante actividad en la TV y en las redes, donde es frecuente encontrar sus reels en Instagram, o sus shorts en YouTube.

Lorena Bello Barreiro

06/12/2025El movimiento feminista ha logrado movilizar conciencias latinoamericanas en la última década, contribuyendo a visibilizar la cuestión de la mujer y de los cuerpos feminizados en sociedades neoliberales regidas por un amplio espectro de violencia basada en situaciones sistemáticas de femicidio, transfemicidios y travesticidios que, atentan, primero, contra el derecho natural de vivir, y de manera simultánea, contra el derecho de llevar una vida libre de violencia.

El 10 de diciembre, Día Internacional de los Derechos Humanos, conmemora la aprobación en 1948 de la Declaración Universal, un hito que marcó el compromiso global con la dignidad, la libertad y la justicia. La fecha invita a reflexionar sobre los avances logrados —como la consolidación de tribunales internacionales y la incorporación de tratados en legislaciones nacionales y también sobre los retrocesos, evidentes en el auge de gobiernos autoritarios, la persecución de minorías y la criminalización de la protesta.